以太坊于 2025 年 12 月 3 日激活了 Fusaka 升级,通过 Blob 参数覆盖逐步扩展了 Blob 目标和最大值,从而提高了网络的数据可用性能力。

随后的两次调整将目标从每个块 6 个 blob 提高到 10 个,然后提高到 14 个,最大上限为 21 个。目标是通过增加 blob 数据的吞吐量来降低第 2 层汇总成本,blob 数据是汇总发布到以太坊的压缩交易包,以确保安全性和最终性。

数据收集三个月后,结果揭示了容量和利用率之间的差距。自 Fusaka 激活以来,MigaLabs 对超过 750,000 个老虎机的分析表明,该网络 未达到目标 blob 计数 14。

在第一次参数调整后,中位 blob 使用率实际上有所下降,并且包含 16 个或更多 blob 的块表现出较高的丢失率,这表明新容量边缘的可靠性下降。

该报告的结论很直接:在高斑点丢失率正常化并且对已创建的净空的需求实现之前,斑点参数不会进一步增加。

富坂改变了什么以及何时发生

以太坊的前 Fusaka 基线, 通过 EIP-7691 建立,将目标设置为每个块 6 个 Blob,最多 9 个。Fusaka 升级引入了两个连续的 Blob 参数覆盖调整。

这 首次于 12 月 9 日激活,将目标提高到 10,上限提高到 15。第二个于 2026 年 1 月 7 日启动,将目标提高到 14,上限提高到 21。

这些改变不需要硬分叉,并且该机制允许 以太坊 通过客户端协调而不是协议级升级来拨号容量。

MigaLabs 分析发布了可重复的代码和方法,跟踪了整个过渡过程中的 blob 使用情况和网络性能。

研究发现,尽管网络容量不断扩大,但每个区块的 Blob 计数中位数从第一次覆盖之前的 6 个下降到之后的 4 个。包含 16 个或更多斑点的块仍然极其罕见,在观察窗口中每个块出现 165 到 259 次,具体取决于具体的斑点计数。

网络有未使用的净空。

一个参数差异:报告的时间线文本将第一次覆盖描述为将目标从 6 提高到 12,但 以太坊基金会 主网公告和客户文档将此次调整描述为 6 至 10。

我们使用 以太坊基金会的参数作为来源:6/9 基线,第一次覆盖后 10/15,第二次覆盖后 14/21。尽管如此,我们将报告中观察到的利用率和错误率模式的数据集视为经验支柱。

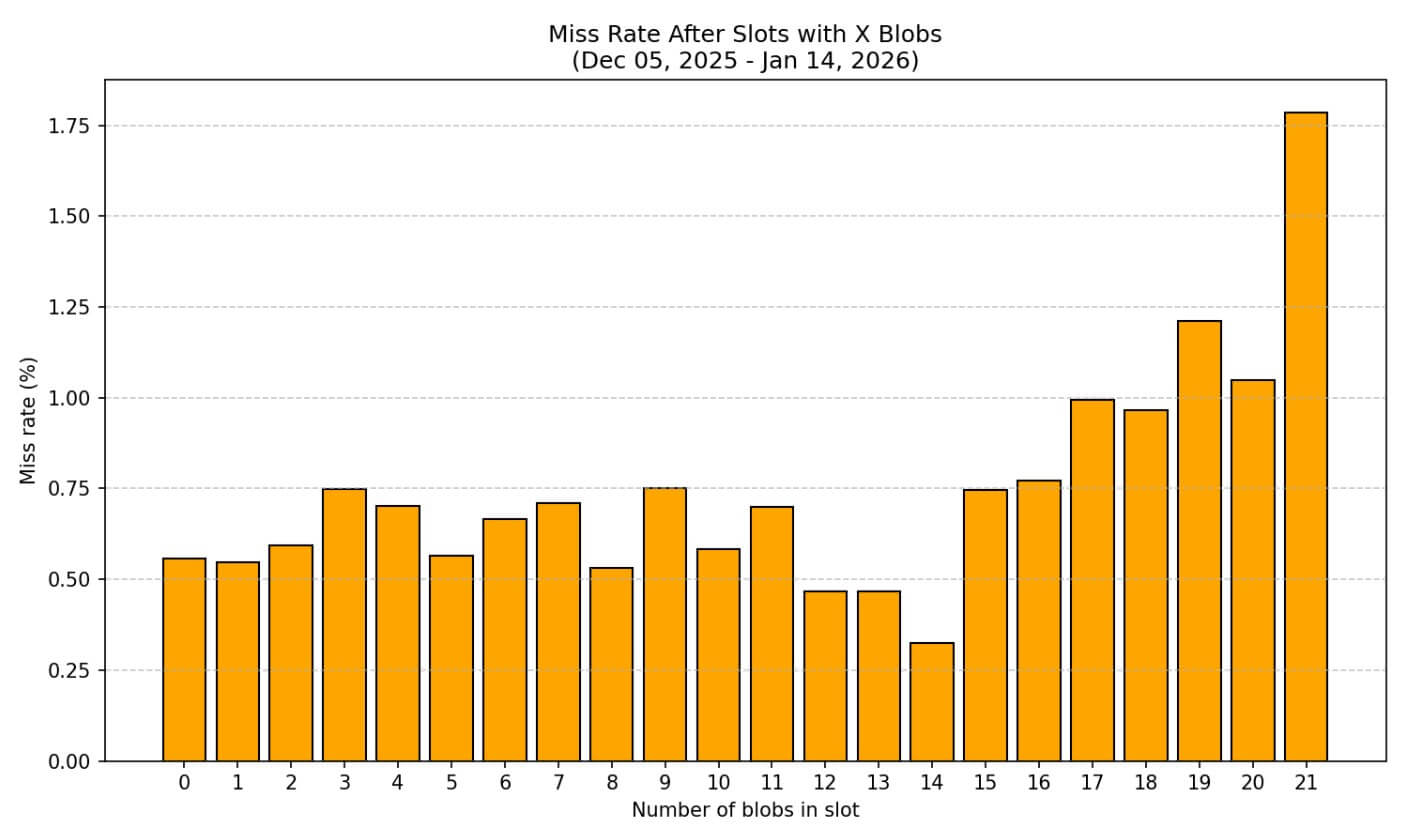

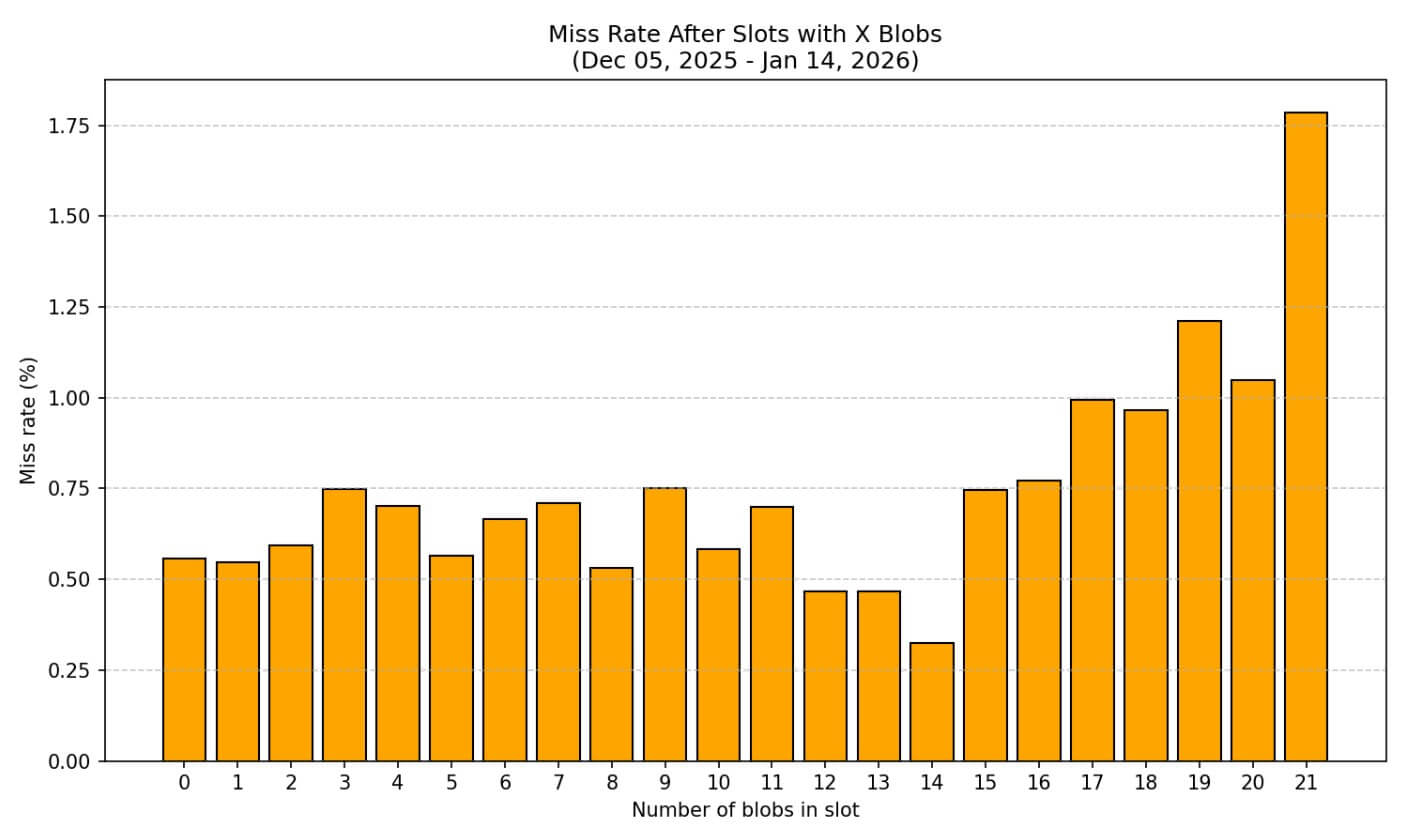

高斑点计数时失误率攀升

通过错过的时隙(无法正确传播或证明的块)来衡量网络可靠性,显示出清晰的模式。

在斑点计数较低时,基线遗漏率约为 0.5%。一旦区块达到 16 个或更多斑点,未命中率就会攀升至 0.77% 至 1.79%。在第二次覆盖中引入的最大容量为 21 个 blob 时,未命中率达到 1.79%,是基线的三倍多。

该分析将其分解为从 10 到 21 的斑点数量,显示了一条逐渐加速超过 14 斑点目标的降解曲线。

这种退化很重要,因为它表明了网络的基础设施,例如 验证器硬件、网络带宽和证明时间,很难处理容量上限的块。

如果需求最终上升以填充 14 blob 目标或推向 21 blob 最大值,则较高的未命中率可能会转化为有意义的最终延迟或重组风险。该报告将此视为稳定性边界:网络在技术上可以处理高斑点块,但始终如一且可靠地处理仍然是一个悬而未决的问题。

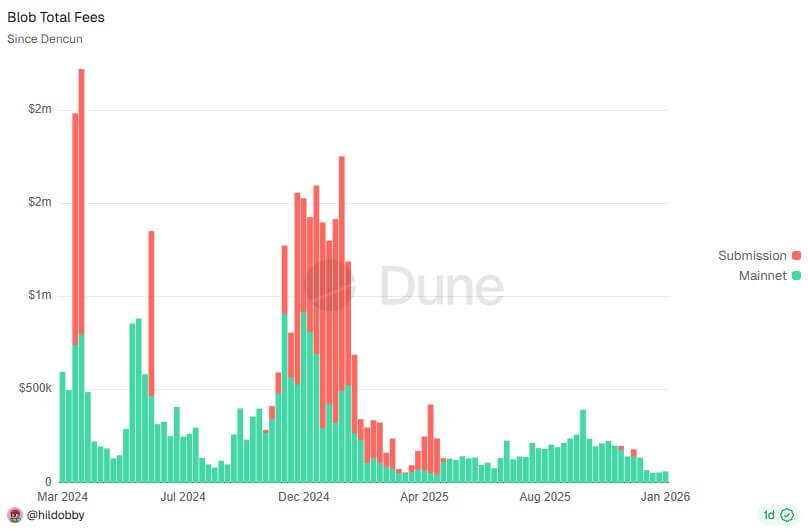

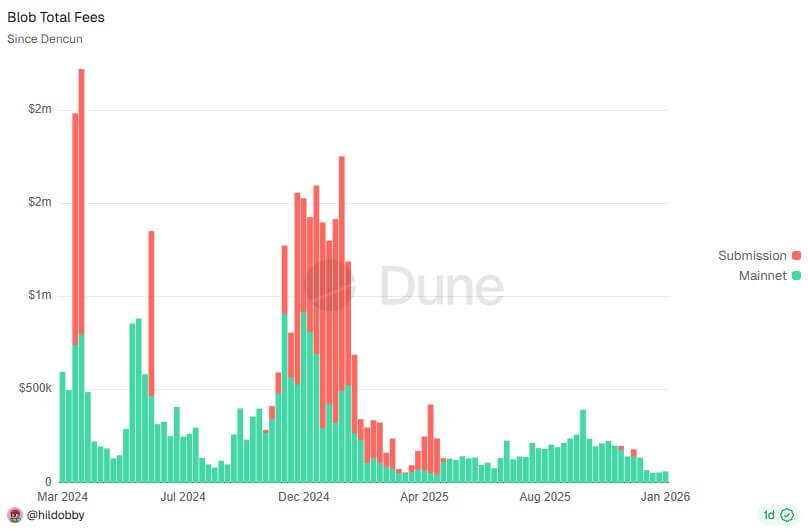

Blob 经济学:为什么底价很重要

富坂不仅扩大了产能。它还通过 EIP-7918 改变了 Blob 定价,引入了底价以防止 Blob 拍卖跌至 1 wei。

在此变化之前,当执行成本占主导地位并且 blob 需求保持较低水平时,blob 基本费用可能会螺旋式下降,直到它作为价格信号实际上消失。 Layer-2 rollups 支付 blob 费用以将其交易数据发布到以太坊,这些费用应该反映 blob 施加的计算和网络成本。

当费用降至接近于零时,经济反馈循环就会中断,并且汇总会消耗容量而无需按比例付费。这导致网络失去对实际需求的可见性。

EIP-7918 的底价下限将 blob 费用与执行成本联系起来,确保即使在需求疲软时,价格仍然是一个有意义的信号。

这可以防止搭便车问题,即廉价的 blob 鼓励浪费使用,并为未来的容量决策提供更清晰的数据:如果尽管容量增加,但 blob 费用仍然较高,则需求是真实的;如果它们倒在地板上,则存在净空高度。

来自希尔多比的早期数据 沙丘 跟踪以太坊 blob 的仪表板显示 blob 费用 富坂之后稳定下来 而不是继续早期出现的螺旋式下降。

每个块的平均 blob 计数证实了 MigaLabs 的发现,即利用率并未激增以填补新容量。块通常携带的数量少于 14 个 blob 的目标,并且分布仍然严重偏向于较低的计数。

数据揭示了哪些有效性

Fusaka 成功地扩展了技术能力,并证明了 Blob 参数覆盖机制可以在不需要有争议的硬分叉的情况下发挥作用。

底价下限似乎正在按预期发挥作用,防止大额费用变得毫无经济意义。但利用率落后于产能,而且新产能边缘的可靠性显示出明显的下降。

失误率曲线表明以太坊当前的基础设施可以轻松处理 Fusaka 之前的基线和第一次覆盖的 10/15 参数,但开始超过 16 个 blob。

这就产生了一个风险状况:如果第 2 层活动激增并将区块定期推向 21 个 blob 的最大值,则网络可能会面临丢失率升高的问题,从而损害最终性和重组阻力。

需求模式提供了另一个信号。尽管容量有所增加,但第一次覆盖后 Blob 使用率中位数有所下降,这表明第 2 层汇总当前不受 Blob 可用性的限制。

要么他们的交易量没有增长到足以需要每个块更多的 blob,要么他们正在优化压缩和批处理以适应现有容量而不是扩大使用量。

Blobscan 是一个专用的 Blob 浏览器,它显示各个汇总随着时间的推移发布相对一致的 Blob 计数,而不是增加以利用新的空间。

Fusaka 之前的担忧是,有限的 blob 容量会成为第 2 层扩展的瓶颈,并随着网络争夺稀缺的数据可用性而导致汇总费用升高。 Fusaka 解决了容量限制问题,但瓶颈似乎已经转移。

Rollup 没有填满可用空间,这意味着需求尚未到来,或者其他因素(例如排序器经济性、用户活动和跨 Rollup 碎片)比 Blob 可用性更限制增长。

接下来会发生什么

以太坊的路线图包括 PeerDAS,这是对数据可用性采样的更根本的重新设计,将进一步扩大 blob 容量,同时提高去中心化和安全属性。

然而,富坂的研究结果表明,原始产能目前并不是约束因素。

在需要再次扩展之前,网络有空间增长到 14/21 参数,并且高 blob 计数的可靠性曲线表明,在容量再次增加之前,基础设施升级可能需要跟上。

未命中率数据提供了明确的边界条件。如果以太坊推高容量,而 16 个以上的 blob 区块仍然显示出较高的错失率,则可能会带来系统不稳定的风险,这种不稳定可能会在高需求时期出现。

更安全的路径是让利用率上升到当前目标,监控未命中率是否随着客户端针对更高的 blob 负载进行优化而改善,并且仅在网络证明其可以可靠地处理边缘情况时才调整参数。

Fusaka 的有效性取决于指标。它成功扩大了产能,并通过储备底线稳定了整体定价。它没有立即提高利用率,也没有解决最大容量时的可靠性挑战。

此次升级为未来的增长创造了空间,但这种增长是否实现仍然是一个悬而未决的问题,数据尚未回答。